こんにちは、スマリズのNaoです。2026年1月12日、テック業界を揺るがすビッグニュースが飛び込んできましたね。

ついにAppleとGoogleがGeminiの採用に関する歴史的な提携を発表しました。

このニュースを見て、両社の提携による株価の変動やAlphabetの時価総額への影響が気になった方も多いのではないでしょうか。

しかし私たちiPhoneユーザーにとって最も重要なのは、進化したSiriへのGemini実装日がいつからなのか、そしてApple Intelligenceの日本語Gemini対応を含めた日本での対応時期がいつになるのかという点ですよね。

また、すでに統合されているApple IntelligenceとChatGPTやGeminiの違いや使い分けはどうなるのか、AppleとGeminiのプライバシーに関するデータ利用の安全性は担保されているのかなど、知りたいことが山積みだと思います。

今回は、これらの疑問について私の視点でわかりやすく解説していきます。

AppleのGoogle Gemini採用の背景と詳細

長年のライバル同士が手を組むという、まさに「呉越同舟」とも言える今回の発表。

ここでは、なぜこのタイミングでAppleがGoogleの技術を必要としたのか、その裏側にある事情や具体的なスケジュールについて掘り下げていきます。

- なぜAppleはGoogleを選んだのか?

- AppleとGemini提携はいつから?実装日

- ChatGPTとGeminiの違いと使い分け

- AppleとGoogle提携後の株価への影響

- Apple Intelligenceの日本語対応時期

なぜAppleはGoogleを選んだのか?

正直なところ、「Appleなら自前で何とかするんじゃないか?」と思っていた方も多いはずです。

私もその一人でした。

Appleはこれまで、iPhoneのチップ(Apple Silicon)のように重要な技術は自社でコントロールすることを美学としてきましたからね。

しかし、今回の決断にはAppleが直面していた「2つの限界」と、Googleが持っていた「圧倒的な武器」が深く関わっています。

まず1つ目の理由は、生成AI開発における「周回遅れ」の解消です。

Apple内部でも「Ajax」や「Ferret」といったコードネームで独自の大規模言語モデル(LLM)の開発が進められていました。

しかし、2025年時点でのベンチマークテストにおいて、GoogleのGemini UltraやOpenAIのGPT-5(仮称)レベルの推論能力には到達できていなかったと言われています。

AIの進化スピードは「ドッグイヤー」どころか「マウスイヤー」です。

ここで無理に自社開発にこだわって、Siriが「賢くないまま」あと1年、2年と放置されれば、iPhone自体の製品価値、ひいてはブランド力が大きく毀損するリスクがありました。

ここがポイント

Appleは、年間約1,500億円とも言われる巨額のライセンス料を払ってでも、すでに完成された世界最高峰のAIモデルであるGoogleのGeminiを導入して「時間を買う」という、極めて合理的かつ現実的な経営判断を下したわけです。

そして2つ目の理由、これが実は決定打だったのではないかと私は睨んでいますが、「インフラの強さ」です。

生成AIを世界中のiPhone(アクティブデバイス数は20億台以上!)で動かすためには、途方もない計算能力を持つサーバー群が必要です。

Googleは自社設計のAI専用チップ「TPU(Tensor Processing Unit)」を搭載したデータセンターを世界規模で展開しており、その処理能力と効率は世界一と言っても過言ではありません。

一方で、競合のOpenAIはMicrosoftのAzureサーバーに依存しており、Apple規模のトラフィックを突然受け入れるにはキャパシティに不安が残ります。

Appleにとって、ユーザーに「Siri、遅い!」と思わせることは絶対に許されません。

24時間365日、爆速で回答を返せるインフラごと提供できるパートナーは、現状Google以外にあり得なかったのだと思います。

AppleとGemini提携はいつから?実装日

一番気になるのは「いつから私のiPhoneで使えるの?」という点ですよね。

この歴史的な機能アップデートがいつ私たちの手元に届くのか、過去のiOSリリースの傾向と、今回の発表内容を照らし合わせて予測してみましょう。

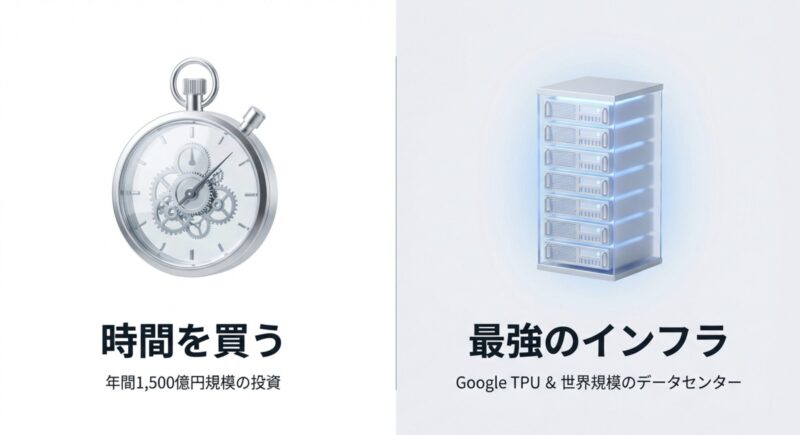

結論から言うと、正式なリリースは2026年の春、具体的には3月から4月頃になる可能性が極めて高いです。

これは、iOSのバージョンで言うと「iOS 19.4」あたりに該当します。

通常、AppleのOSアップデートサイクルは以下のようになっています。

| 時期 | バージョン | 内容 |

|---|---|---|

| 9月 | x.0 | メジャーアップデート(新型iPhone発売) |

| 10-12月 | x.1 – x.2 | 初期バグ修正と予告されていた機能の追加 |

| 3-4月 | x.4 | 春の大型機能追加(ここに注目!) |

| 6月 | 次期OS発表 | WWDCでの次世代OSプレビュー |

過去の例を見ても、iOS 17.4でのEU向け機能開放や、iOS 18.4でのSiriの大幅な言語理解アップデートなど、春のタイミングは「OSの完成形」とも言える重要な機能が実装されることが多いんです。

今回のようなシステム根幹に関わる変更は、9月の初期リリースには間に合わず、安定性を確保してから春に投入されるのが通例です。

具体的な流れとしては、まず2026年1月〜2月にかけて開発者向けベータ版(Developer Beta)でGemini搭載Siriがテスト解禁され、そこでバグ出しが行われます。

その後、パブリックベータを経て、一般ユーザーには桜が咲く頃に届く…というタイムラインですね。

メモ

ただし、これはあくまで「米国版」の話です。

世界同時リリースを目指すとは思いますが、AI機能に関しては言語ごとの調整が難しいため、地域によってタイムラグが発生することは覚悟しておいた方が良いかもしれません。

ChatGPTとGeminiの違いと使い分け

「あれ?この前ChatGPTとも連携したよね?」「私のiPhoneにはどっちが入るの?」と混乱してしまう方も多いはずです。

ここが今回のニュースの少しややこしい部分であり、同時に面白い部分でもあります。

Appleの中では、この2つのAIは明確に役割分担がなされています。

ざっくり言うと、Geminiは「Siriの脳みそ(基盤)」として動き、ChatGPTは「外部の物知りな先生(アドオン)」として動くイメージを持ってください。

それぞれの違いを表にまとめてみました。

| 特徴 | Google Gemini (今回採用) | OpenAI ChatGPT (既存) |

|---|---|---|

| ポジション | OS統合(内蔵) | 外部連携(拡張機能) |

| 主な役割 | Siriの基本機能。推論、計画、要約、文脈理解、アプリ操作。 | 必要に応じて呼び出す辞書・相談役。創作、専門知識の回答。 |

| ユーザー体験 | 見えない(White Label)。「Siri」として振る舞う。 | 見える。「ChatGPTを使いますか?」と許可を求められる。 |

| プライバシー | Appleの管理下(PCC)で処理。Googleはデータを見れない。 | OpenAIにデータが送られる(IPアドレスは隠蔽される)。 |

| コスト | 無料(標準搭載) | 基本無料(有料プラン連携あり) |

例えば、あなたが「明日のスケジュールを確認して、ランチの場所を予約して」とSiriに頼んだとします。

この時、カレンダーアプリを確認し、レストラン予約アプリを操作するのはGeminiの役割です。

これはiPhoneの内部機能と密接に関わるため、より深く統合されたGeminiが処理します。

ユーザーはGoogleが動いていることを一切意識しません。

一方で、「『猫が宇宙へ行く』というテーマで面白いショートストーリーを書いて」とか、「量子力学について小学生でもわかるように教えて」といったリクエストをした場合、Siriは「それは私が答えるより、あいつに聞いた方がいいな」と判断します。

そして「ChatGPTを利用して回答しますか?」と提案してくるわけです。

つまり、これからは「意識せず普段使いするGemini」と「あえて選んで使うChatGPT」という使い分けが、私たちの生活に自然と馴染んでいくことになるでしょう。

最強のエンジン(Gemini)と最強の辞書(ChatGPT)の両方を装備したSiriは、まさに無敵状態と言えるかもしれません。

AppleとGoogle提携後の株価への影響

この歴史的な提携発表直後、Googleの親会社であるAlphabetの時価総額は一時4兆ドルを突破するなど、市場は熱狂的な反応を見せました。

もちろんAppleの株価も堅調に推移しています。

なぜ投資家たちはこの提携をここまでポジティブに捉えたのでしょうか?

その理由は、この提携が双方にとって完璧な「Win-Win(相互利益)」の関係にあるからです。

Google(Alphabet)のメリット

- AI覇権の確立:Androidだけでなく、最大のライバルであるiOSのエコシステムにも自社のAI「Gemini」を浸透させることで、モバイルAI市場における事実上の標準(デファクトスタンダード)を握ることができます。

- データ優位性:AIは使われれば使われるほど賢くなります。20億台のiPhoneユーザーがGeminiを使うことで得られるフィードバック(※プライバシー保護のためデータそのものではなく、モデルの改善につながる知見)は、競合他社が追いつけない圧倒的な参入障壁となります。

Appleのメリット

- リスク回避と実利:巨額の設備投資をして自前のデータセンターを建設し、一からAIモデルを開発するリスクを回避できます。「餅は餅屋」の発想で、最高の技術を外部から調達し、Appleが得意な「ユーザー体験(UX)の統合」に集中できるのです。

- Siriの復権:長年「使えない」と揶揄されてきたSiriを一気に最先端レベルへ引き上げることで、iPhoneのハードウェアとしての価値を維持・向上させることができます。

一部のアナリストからは「Googleへの権力集中が進みすぎるのではないか?」という独占禁止法上の懸念も指摘されていますが、短期的には両社のシナジー効果が企業の収益力を高めると評価されています。

私たちユーザーとしても、両社の強みが合わさることでより便利な製品が手に入るなら、それは歓迎すべきことですよね。

Apple Intelligenceの日本語対応時期

さて、私たち日本のユーザーにとって最も切実な問題はここです。

「で、日本語でその賢いSiriと話せるのはいつなの?」という点です。

残念ながら、Geminiを搭載した次世代Siriの日本語対応は、米国版のリリース(2026年春)からは少し遅れる可能性が高いと見ておくのが無難です。

Apple Intelligence自体の日本語対応は2025年から順次始まっていますが、今回のGeminiベースのアップデートは、より高度な言語理解と文脈解釈を必要とするため、ローカライズ(現地語対応)のハードルが格段に上がるからです。

日本語は「主語を省略する」「文脈で意味が変わる(ハイコンテクスト)」といった特徴があり、AIにとっても難易度が高い言語の一つです。

英語での推論精度をそのまま日本語で再現するには、相当な調整期間が必要です。

予測スケジュール

過去のSiriの大型アップデートや機能追加のラグを考慮すると、日本語での本格対応は2026年の後半、iOS 20が登場する秋頃、あるいは早くても2026年の夏頃になるのではないかと予想しています。

「また日本は後回しか…」とがっかりされるかもしれませんが、逆に見れば、米国でのバグ出しが終わって洗練された状態で日本に届くとポジティブに捉えることもできます。

まずは英語圏での評判やレビュー動画などをチェックしながら、楽しみに待ちたいところですね。

AppleによるGoogle Gemini採用の影響

ここからは、実際に私たちの手元にあるiPhoneがどう変わるのか、もっと具体的な使い勝手の部分や、多くの人が懸念しているであろう「プライバシー」について、技術的な裏付けも含めて詳しく解説していきます。

- Gemini搭載の次世代Siriでできること

- AppleとGeminiのプライバシー安全性

- 対応するiOSバージョンと機種は?

- 今後のAppleとGoogleの関係性と展望

- AppleのGoogle Gemini採用の総括

Gemini搭載の次世代Siriでできること

「AIが入ると便利になる」と言われても、具体的に生活がどう変わるのかイメージしづらいですよね。

Geminiが入ることで、Siriは「ただの音声リモコン(アラームセット係)」から、真の意味での「パーソナル・エージェント(秘書)」へと進化します。

私が特に期待している、生活を激変させる3つの新機能について解説します。

1. 文脈を理解し続ける「コンテキスト・アウェアネス」

これまでのSiriとの会話で一番イライラしたのは、「会話が続かないこと」ではありませんでしたか?

「東京の天気を教えて」→「晴れです」→「そこまでの飛行機代は?」→「Webで検索します」

このように、Siriは直前の会話の内容(ここでは「東京」のこと)をすぐに忘れてしまっていました。

しかし、Gemini搭載のSiriは違います。

「東京の天気は?」→「晴れです」→「じゃあ、来週の週末にそこへ行くフライトを探して」→「承知しました。来週末の東京行きの便を検索します。JALとANAどちらが良いですか?」

このように、「そこ」「あれ」「それ」といった指示語を、前の会話の流れから正確に理解してくれます。

まるで人間と話しているような自然なキャッチボールが可能になるのです。

2. 画面の内容を理解する「On-Screen Awareness」

これは地味ですが革命的な機能です。Siriが「今あなたがスマホの画面で見ているもの」を認識できるようになります。

例えば、Instagramで美味しそうなランチの写真を見ている時に、Siriを起動して「この店を予約して」と言うだけでOKです。

Siriは画面上の画像やテキストから店名を特定し、レストラン予約アプリや電話機能を立ち上げてくれます。

いちいち店名をコピペして検索し直す手間から解放されるんです。

これは、Geminiが得意とする「マルチモーダル(画像と言語の同時処理)」の能力がいかんなく発揮される場面ですね。

3. 複数のアプリを横断する「究極の自動化」

「昨日撮った子供の写真を、明るくきれいに補正して、PDFに変換して、おばあちゃんへのメールに添付して送っといて」。

こんな複雑な命令、今のSiriにしたら「すみません、よくわかりません」と返されるのがオチです。でも、次世代Siriは違います。

- 「写真アプリ」から昨日の写真を探す

- 「画像編集機能」で補正する

- 「ファイルアプリ」でPDF化する

- 「メールアプリ」でおばあちゃんのアドレスを呼び出して添付する

この一連の作業(ワークフロー)を、Siri自身がプランニングして自動で実行してくれます。

私たちがやるのは、最後の「送信」ボタンを押す確認だけ。

面倒な事務作業やルーチンワークをSiriに丸投げできる未来が、すぐそこまで来ています。

AppleとGeminiのプライバシー安全性

「機能が凄いのはわかった。でも、GoogleのAIを使うってことは、私のメールや写真、会話の内容が全部Googleに送られて覗かれるってこと?」

この不安、痛いほどわかります。

Googleは広告会社であり、データを集めることがビジネスの根幹ですから、警戒するのは当然です。

しかし、結論から言うと「その心配は不要」です。

Appleはこの提携において、プライバシー保護のためにこれ以上ないほど強固な防壁を築いています。

鉄壁の守り:Private Cloud Compute (PCC)

Appleは、Geminiを動かすために「Private Cloud Compute (PCC)」という独自のクラウドシステムを構築しました。

これは、Googleのサーバーをそのまま使うのではなく、Appleシリコン(自社製チップ)で構築されたApple専用のサーバー上で、カスタマイズされたGeminiを動かす仕組みです。

このPCCには、以下の厳格なルールが適用されています。

- データ非共有(No Data Sharing):契約上、GoogleはAppleユーザーのデータに一切アクセスできません。処理はAppleの管理下にあるサーバー内(セキュリティバウンダリの内側)で完結します。

- 学習利用の禁止:私たちのSiriとの会話データや個人情報を使って、GoogleがGeminiを再学習(トレーニング)させることは禁止されています。あなたのデータが、誰かのAIの回答に使われることはありません。

- ステートレス処理:リクエストの処理が終わったら、データは即座に消去されます。サーバー上にログや履歴が残ることもありません。

- 検証可能性:このセキュリティの仕組みは、第三者のセキュリティ専門家が検証できるよう公開されています(出典:Apple Security Research『Private Cloud Compute: A new frontier for AI privacy in the cloud』)。

つまり、Googleから借りてきたのは「脳みその設計図(モデル)」だけであり、それを動かす「場所(サーバー)」と「データ」は完全にAppleが握っている状態です。

これを専門用語で「エアギャップ」に近い環境と呼びますが、要するに「Google側からは、iPhoneから何のリクエストが来ているか全く見えない」状態になっているのです。

対応するiOSバージョンと機種は?

ここまで読んで「早く使いたい!」と思った方、ちょっと待ってください。

この高度なAI機能を動かすには、スマホ側にも相応の「体力(スペック)」が求められます。

次世代Siriは、簡単な処理はiPhone本体の中で行い(オンデバイス処理)、複雑な処理だけをクラウド(PCC)に投げるというハイブリッドな動きをします。

そのため、AI処理専用の回路である「Neural Engine」の性能が低い古い機種では、残念ながら動作対象外となる可能性が高いです。

現時点での有力な予測対応機種は以下の通りです。

| デバイス | 対応チップ | 機種名(予測) |

|---|---|---|

| iPhone | A18 / A19以降 | iPhone 16シリーズ全機種 iPhone 17シリーズ(2026年発売予定) |

| iPad | M4 / M5以降 | iPad Pro (M4モデル) 次期iPad Airなど |

| Mac | M1以降(推奨M3/M4) | Appleシリコン搭載Mac全般 (一部機能はM3以降に限定される可能性あり) |

特にiPhoneに関しては、メモリ(RAM)の容量も重要です。

AIモデルを動かすには最低でも8GB以上のメモリが必要と言われており、iPhone 15 Pro以前のモデル(メモリ6GB以下の機種)では、OSをiOS 19や20にアップデートしても、このGemini搭載Siriの機能だけは制限される、あるいは使えないという残酷な線引きが行われるでしょう。

メモ

もしあなたが現在、iPhone 13や14、あるいは15の無印モデルを使っているなら、2026年の春、または秋の新型iPhone発売のタイミングが、買い替えの絶好のチャンスかもしれません。

「AIが使えるスマホ」と「使えないスマホ」で、体験の差が天と地ほど開く時代がすぐそこまで来ています。

今後のAppleとGoogleの関係性と展望

今回の提携によって、モバイルAIの世界地図は大きく塗り替わりました。

AndroidとiOS、世界の二大モバイルOSが、どちらもGoogleのGeminiを標準採用することになったのですから、Googleにとってはまさに「AI覇権」を握ったと言っても過言ではありません。

しかし、AppleとGoogleがこれで永遠に蜜月関係を続けるかというと、私はそうは思いません。

Appleにとって、他社の技術(特にライバルのGoogleの技術)に自社製品の核心部分を依存し続けることは、長期的にはリスクだからです。

Appleは現在も、水面下で自社製LLM「Ferret」や次世代チップの開発に莫大な投資を続けています。

彼らが目指しているのは、クラウドに頼らず、iPhoneの中だけですべてのAI処理を超高速かつ安全に行う「完全なオンデバイスAI」の世界でしょう。

数年後、iPhoneのチップ性能(A20やA21など)が飛躍的に向上し、自社モデルの精度がGeminiに追いついた時、Appleは「脱Gemini」へと舵を切るかもしれません。

「これからはApple独自のAIで動きます」と発表し、Googleへの依存を断ち切る未来――これは十分にあり得るシナリオです。

今回の提携は、あくまでAppleが自社技術を完成させるまでの「強力なつなぎ(ショートリリーフ)」であり、同時にGoogleにとっては「自社AIを世界標準にするための絶好の機会」です。

お互いの利害が一致している今のうちは手を組みますが、数年後の関係がどうなっているか、テック業界のドラマはまだまだ続きそうです。

AppleのGoogle Gemini採用の総括

最後に、今回のAppleとGoogle Gemini採用のニュースについて、重要なポイントをまとめておきましょう。

記事のまとめ

- Appleは自社AI開発の遅れを挽回し、Siriを劇的に進化させるために、Google Geminiを採用するという現実的な戦略を選んだ。

- 実装時期は2026年春(iOS 19.4頃)が有力だが、日本語対応はさらに半年程度遅れて2026年秋頃になる可能性がある。

- ユーザーからはあくまで「賢くなったSiri」として見え、ChatGPTとは「内蔵の脳」と「外部の辞書」という形で明確に役割分担されている。

- プライバシーに関しては、Apple独自の「Private Cloud Compute」により鉄壁に守られており、個人のデータがGoogleに渡ることはない。

個人的には、長年愛用してきたiPhoneのSiriが、ついに「ただの音声入力係」を卒業し、私の意図を汲み取ってくれる頼れる相棒になってくれることに、期待で胸がいっぱいです。

「ヘイSiri」と呼びかけるのが、今よりもっと楽しく、もっと便利になる未来。

早く体験してみたいですね!

正式なリリース日や日本語対応の詳細なスケジュールなど、新しい情報が入り次第、またこのブログ(スマリズ)で速報として更新してお知らせします。

ぜひブックマークして待っていてくださいね!